Depuis une dizaine d’années, des logiciels évaluent l’attribution de certaines aides sociales ou traquent les fraudes. Entre biais et risques d’erreurs, leur implémentation se révèle plus compliquée que prévu.

TEXTE | Aurélie Toninato

Ils sont utilisés pour prédire le développement d’un cancer, anticiper la survenue d’un cambriolage, évaluer le risque que représente une assurée ou un assuré. Eux, ce sont les algorithmes prédictifs. Soit une suite d’opérations automatisées permettant de résoudre un problème et qui, en se basant sur un socle d’informations fournies par l’être humain, va repérer des régularités, classifier, typologiser puis s’en servir pour prédire un comportement ou un risque. «Le but est d’offrir un système de support à la prise de décision dans la délivrance de services, de prestations ou de droits», relèvent Maël Dif-Pradalier et Thomas Jammet, sociologues, respectivement professeur et adjoint scientifique à la Haute école de travail social Fribourg – HETS-FR – HES-SO.

Depuis une dizaine d’années, le recours aux algorithmes prédictifs se généralise dans le domaine social ou judiciaire. Aux États-Unis par exemple, des logiciels calculent le risque de récidive d’un criminel et lui attribuent un score qui influence la durée de sa peine. La ou le juge peut outrepasser cet «avis», mais doit fournir une argumentation. L’action de ces outils s’étend désormais à l’aide sociale. «À la base de leur utilisation dans ce domaine, on trouve en général une volonté légitime de mieux connaître les destinataires des dispositifs sociaux et d’adapter ces derniers à leurs besoins, estiment les deux experts. L’idée consiste à proposer une prise de décision facilitée pour les travailleuses et les travailleurs sociaux, à gagner en réactivité dans la délivrance de prestations, ou encore à atteindre une forme d’équité de traitement débarrassée d’a priori.»

Des visées de contrôle et d’identification des fraudeurs

Voilà pour la théorie. Mais en pratique, les forces des algorithmes peuvent devenir des faiblesses et entraîner des dérives dans le contexte d’une dématérialisation administrative. Tout d’abord, il faut rappeler que lorsqu’on rend un nombre croissant de services accessibles uniquement en ligne – c’est notamment le cas de la caisse des allocations familiales en France –, cela représente une difficulté pour une partie de la population. «La dématérialisation se construit sur un profil type d’utilisatrice ou d’utilisateur compétent dans l’usage du numérique, sans tenir compte des difficultés de ceux qui ont le plus besoin de ces aides», note Thomas Jammet.

Le contexte dans lequel sont élaborés ces outils a également une influence. «Lorsqu’ils sont développés dans un objectif de rationalisation ou d’économies, les algorithmes d’allocation des ressources, par exemple, auront des visées de contrôle et d’identification des fraudeuses et des fraudeurs, soutiennent les chercheurs. On se trouve davantage face à une sorte de gestion de la paupérisation qu’à un accompagnement garantissant à toutes et tous une part équitable des moyens à disposition.»

La rationalisation contraint les systèmes automatisés de soutien à la prise de décision à toujours plus de performance et d’efficacité. Or, ceux-ci ne sont souvent pas neutres. Ils sont alimentés par des données constituées par des êtres humains. Dans son livre Automating Inequality: How High-tech Tools Profile, Police and Punish the Poor (2018), la professeure de sciences politiques américaine Virginia Eubanks soutient qu’on remplace des biais par d’autres, la subjectivité des travailleurs sociaux par celle des conceptrices et des concepteurs. Selon elle, certains algorithmes prédictifs vont même reproduire et amplifier les discriminations à l’encontre des plus pauvres, en «automatisant» les inégalités. Pour les deux experts de la HETS-FR, la sélection des informations initiales et les choix opérés à ce stade sont déterminants: «Dans la constitution de la base de données, on entre certaines données et pas d’autres, on accorde une valeur à certains éléments, on décide ce qui constitue un délit ou au contraire un comportement attendu ou méritant. Cela va donner lieu à une catégorisation de personnes jouissant de droits différenciés.» Ils évoquent un algorithme d’attribution des allocations familiales aux Pays-Bas conçu sur une base discriminante de profilage ethnique: être de nationalité étrangère figurait parmi les critères du système pour marquer un individu comme suspect. Plusieurs milliers de familles ont été accusées à tort de fraude. Certaines ont dû restituer rétroactivement les aides perçues. En 2021, ce scandale a eu raison du gouvernement néerlandais, qui a démissionné.

Ces outils numériques visent souvent ceux qui demandent des aides, placés sous surveillance constante. Le logiciel des Pays- Bas sus-mentionné a été conçu pour poursuivre les fraudes à l’aide sociale, en croisant des données – fiscales, sociales et de santé notamment – et en alertant en cas d’anomalies. Il a été implanté uniquement dans certains quartiers, les plus défavorisés. «Il y avait donc une suspicion dès le départ, une partie de la population était jugée ‹à problèmes› et catégorisée comme potentiellement fraudeuse», résument Maël Dif-Pradalier et Thomas Jammet. En 2020, ce système a été jugé contraire à la Convention européenne des droits de l’homme.

Est-ce à dire que l’on constate un changement de paradigme dans l’aide sociale, dont les objectifs initiaux de soutien sont remplacés par la seule volonté de traquer et de réprimer? Maël Dif-Pradalier nuance: «Il existe depuis toujours une tension entre aider et contrôler, une recherche d’un point d’équilibre entre un soutien et une responsabilisation, et des attentes de contreparties en termes de conformité morale ou comportementale. Sans parler d’un changement de paradigme proprement dit, on peut évoquer un nouveau stade où certaines administrations trouvent, dans ces outils, des instruments au service de plus de contrôle et d’une suspicion généralisée.»

Qui incriminer en cas d’erreur

Dans cette nouvelle étape, on utilise des modes de calculs qui ne sont pas infaillibles et par essence jamais neutres. Ils commettent des erreurs qui peuvent avoir de lourdes conséquences. Le programme Robodebt en Australie a envoyé des mises en demeure de paiement de dettes erronées, calculées par un algorithme à quelque 40’000 personnes. Le système a été abandonné en 2019, «mais des personnes lésées sont encore en attente de remboursement, certaines ont tout perdu, relèvent les deux spécialistes. Il existe un décalage énorme entre la reconnaissance d’un problème et l’indemnisation de la victime.»

En cas d’erreur, difficile en effet de faire valoir ses droits. Impossible de simplement se présenter à un guichet. Et qui incriminer? Les concepteurs de l’algorithme? Le gouvernement qui l’utilise ? «Il règne une certaine opacité, les algorithmes prédictifs constituent une boîte noire, analyse Thomas Jammet. On sait ce qui entre et ce qui sort, mais on ne sait pas ce qui s’est passé exactement à l’intérieur. Contester une décision devient alors compliqué.»

Des prédictions qui ne doivent pas se substituer aux professionnels

Malgré ces écueils, tout n’est pas à jeter dans ces outils prédictifs. Ils peuvent représenter «une réelle plus-value dans l’aide à la décision», selon les deux experts. Mais avec des garde-fous: «Les algorithmes ne doivent pas être des décisionnaires en l’absence de contrôle humain. Ils doivent soutenir le travail de la prise de décision mais pas se substituer aux professionnel·les.» Il faut également interroger leur pertinence, y compris financière, dans le domaine social. Les sociologues relèvent ainsi que la proportion entre le non-recours aux prestations et la fraude sociale est sans commune mesure, la première étant bien supérieure à la seconde. Et bien souvent, «les coûts induits pour récupérer les effets collatéraux de ces systèmes algorithmiques sont plus importants que les dépenses dans ce système. Les efforts des gouvernements se concentrent sur des fraudes qui ne sont pas celles qui grèvent le plus son budget, l’évasion fiscale pèse davantage.» Enfin, il faut pouvoir auditer les algorithmes et mesurer leur neutralité.

En Suisse, dans le domaine social, Thomas Jammet et Maël Dif-Pradalier n’ont connaissance que d’un exemple d’algorithmes prédictifs: un système qui attribue les réfugié·es aux cantons en fonction de la situation locale de marché du travail et de leurs chances d’insertion professionnelle. Mais le programme ne tient pas compte d’autres éléments plus difficiles à objectiver, comme la présence de membres de la famille. Ils peuvent pourtant favoriser cette insertion.

Serait-il envisageable que des systèmes comme ceux implantés aux États-Unis ou aux Pays-Bas soient utilisés en Suisse? «Il faut espérer que les scandales récents servent de leçons, répondent les spécialistes. Ou tout du moins qu’on ne reproduise pas les mêmes biais. Le fédéralisme peut représenter un garde-fou : le social dépend d’arbitrages avant tout communaux et cantonaux. Cela permet d’éviter la reproduction d’inégalités à grande échelle.»

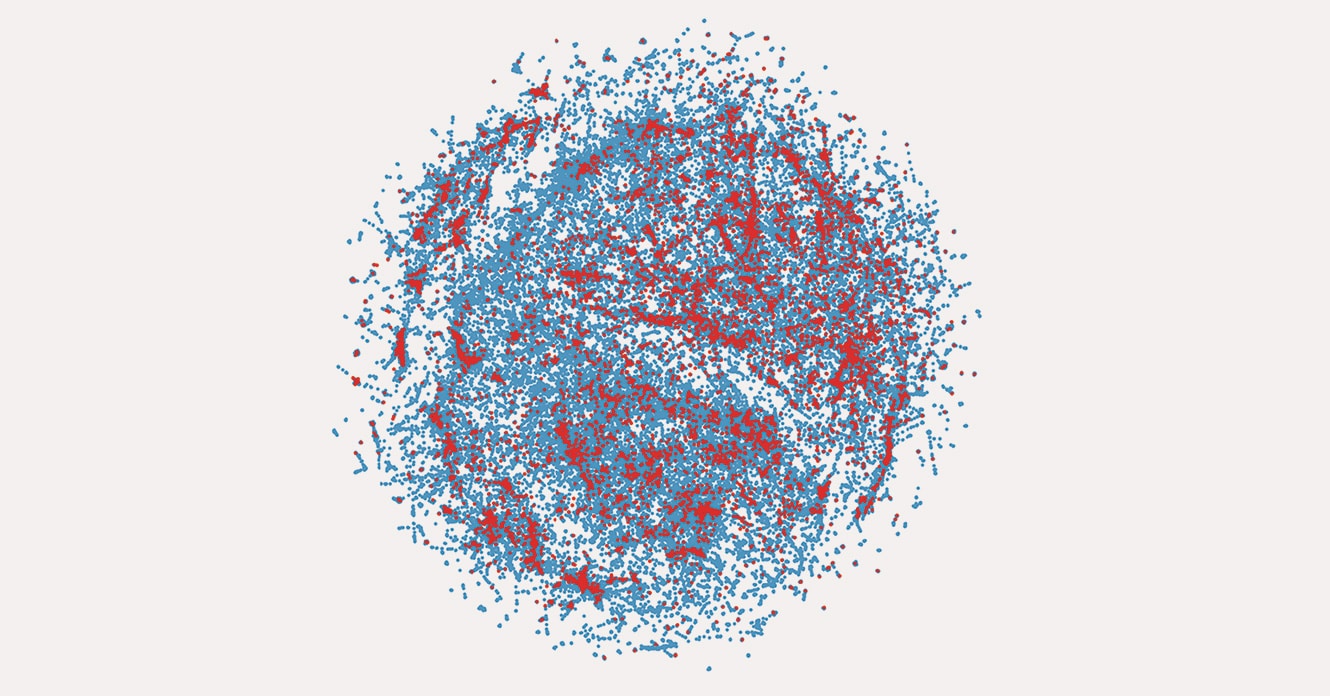

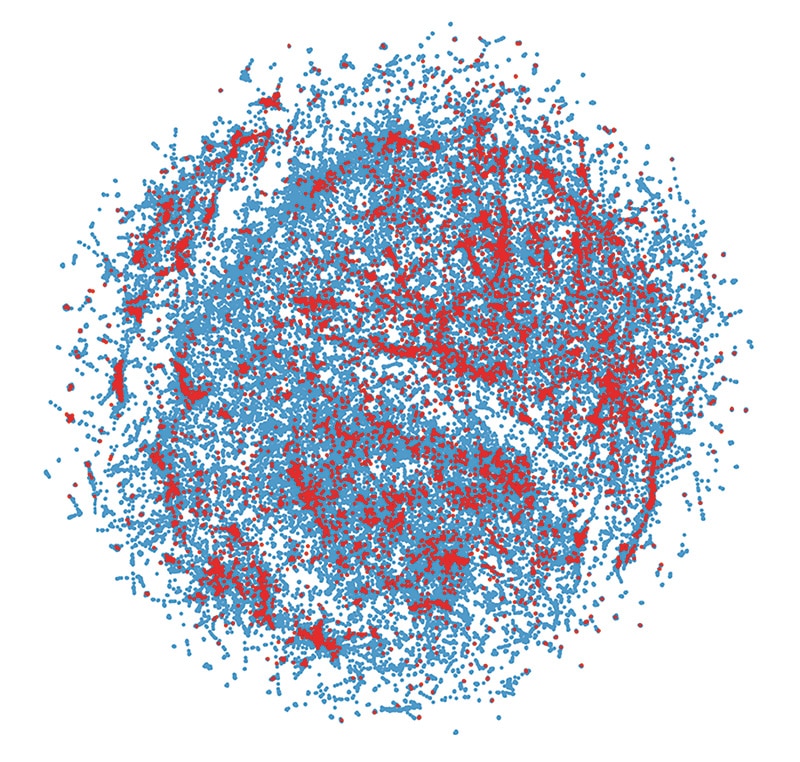

Le secteur public suisse utilise des systèmes de décision automatisée

L’ONG AlgorithmWatch Switzerland, soutenue par le Fonds pionnier Migros, plaide pour une utilisation des systèmes algorithmiques qui ne nuise pas à la société. Elle est active dans la recherche, le développement d’outils pour évaluer les systèmes de prise de décision automatisée (ADM), la production de propositions de lois pour encadrer ces derniers, entre autres. En 2020, l’ONG a coproduit le rapport Automation Society 2020 sur l’usage de ces ADM. Il montre que le secteur public suisse utilise ces systèmes de manière sélective, mais pas de manière globale. Et de citer l’exemple du logiciel allemand Precobs, utilisé par les cantons de Zurich, Zoug, Argovie et Bâle-Campagne, qui vise à prédire les cambriolages à partir de données historiques, en partant de l’hypothèse que les cambrioleuses et les cambrioleurs frappent plusieurs fois au même endroit dans un bref laps de temps s’ils y ont déjà réussi leurs méfaits. Autre exemple: des cantons germanophones utilisent un logiciel pour filtrer les cas de délinquance nécessitant une évaluation plus poussée. Le programme classe leurs auteur·es dans trois catégories en fonction du risque de récidive sur la base de différents critères (casier judiciaire, âge, infractions violentes commises avant 18 ans, nombre de condamnations antérieures, catégorie de l’infraction, etc.). Les ADM sont également utilisés dans la santé, aux Hôpitaux universitaires de Genève, notamment, comme aide pour diagnostiquer les cancers. Ils peuvent détecter une anomalie en comparant une radiographie à des millions d’autres images. Les oncologues peuvent proposer le traitement le plus approprié sur la base d’hypothèses formulées par le logiciel capable de compiler une masse de données qui comprend, entre autres, des revues spécialisées ou des dossiers de patient·es.